[딥테크] 작동하는 인공지능, 올라가는 지구 온도

입력

수정

AI 확산으로 데이터센터 전력 소비 급증 뒤처진 효율 기준과 정책 대응 한정된 전력, 사회적 가치 따라 연산 자원 배분 필요

The Economy의 연구 팀의 The Economy Research 기고를 번역한 기사입니다. 본 기고 시리즈는 글로벌 유수 연구 기관의 최근 연구 결과, 경제 분석, 정책 제안 등을 평범한 언어로 풀어내 일반 독자들에게 친근한 콘텐츠를 제공하는데 목표를 두고 있습니다. 기고자의 해석과 논평이 추가된 만큼, 본 기사에 제시된 견해는 원문의 견해와 일치하지 않을 수도 있습니다.

인공지능(AI)이 생성하는 응답 한 줄에도 전기가 든다. 불과 10년 전까지만 해도 '클라우드'는 종이와 이동을 줄이는 친환경 기술로 주목받았지만, 2025년 현재 AI 연산이 촘촘히 얽힌 클라우드는 오히려 탄소 배출의 새로운 진원지로 떠올랐다. 기술은 고도화됐지만, 그 이면에는 빠르게 불어나는 전력 소비와 이에 따른 배출이 따라붙는다.

늘어나는 데이터센터 전력 소비

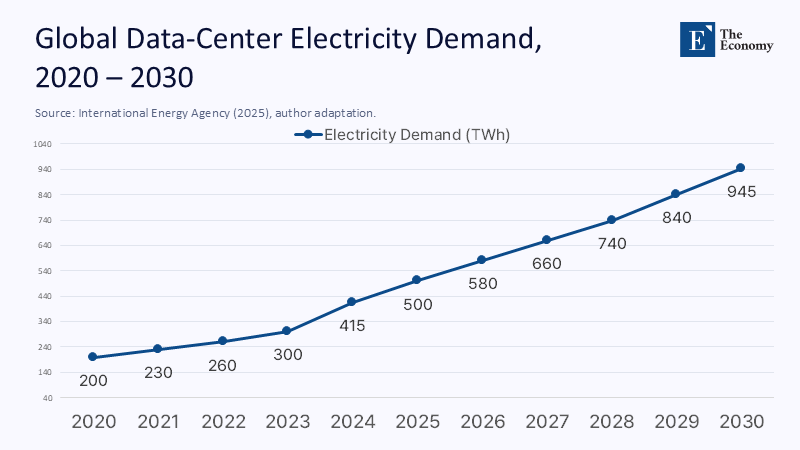

AI가 구동되는 배경에는 물리적인 데이터센터가 있다. 2024년, 전 세계 데이터센터의 전력 사용량은 415TWh로, 이는 사우디아라비아의 연간 전력 수요에 맞먹는다. 아직 생성형 AI가 본격적으로 확산되기 전임에도 이 정도다. 국제에너지기구(International Energy Agency, IEA)는 이 수치가 2030년에는 945TWh에 이를 것으로 전망한다. 일본 전체 전력 소비량을 웃도는 규모다. 디지털 전환은 전력 절약이 아닌, 에너지 구조의 재편을 의미하게 됐다.

성능에 몰린 전력 부담

이 같은 전력 소모를 주도하는 것은 AI 연산을 담당하는 GPU다. 엔비디아의 H100 GPU는 장당 최대 700W를 소모하고, 이를 8장 장착한 서버 한 대만으로도 5.6kW 이상을 요구한다. 스토리지, 냉각 시스템까지 포함해 10만 장 규모의 클러스터가 가동되면 약 150MW가 필요하다. 이는 중형 원자력 발전소 절반 수준에 달한다. 과학 저널 사이언티픽 아메리칸(Scientific American)은 이 같은 추세가 지속될 경우, 데이터센터 전력 소비가 향후 5년 내 두 배로 늘 수 있다고 경고했다.

주: 연도(X축), 전력수요(Y축)

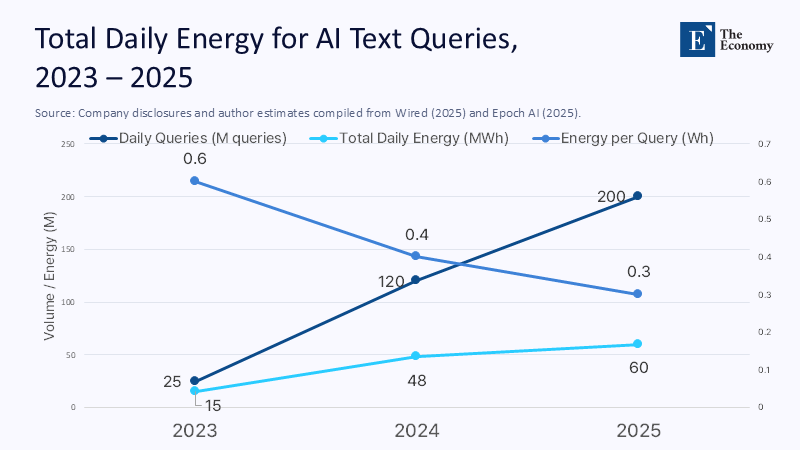

GPT-4o 기준으로 챗봇 질의 한 건에 소모되는 전력은 약 0.3~0.34Wh다. 적은 수치지만, 하루 2억 건 이상이 쌓이면 60MWh에 달하며 이는 유럽 가정 약 5,000가구의 하루 전력 사용량과 맞먹는다. 특히 교육 분야에서 AI 기반 수업 도구와 학습 앱이 빠르게 확산되는 만큼, 관련 전력 소비는 더 증가할 가능성이 크다.

훈련은 끝나도, 탄소는 남는다

AI는 서비스를 시작하기 전, 대규모 훈련 과정을 거친다. GPT-3는 훈련에 1,287MWh를, 오픈소스 모델 BLOOM은 433MWh를 소비했다. GPT-4는 이보다 규모가 훨씬 커 훈련 과정에서만 7,100~1만5,000tCO₂e(이산화탄소톤 환산)의 탄소를 배출한 것으로 추정된다. GPT-3보다 최대 12배 많다. 한 번의 훈련으로 배출되는 이 막대한 탄소는 이후 수많은 질의응답에서 높은 에너지 효율로 운영돼야 겨우 상쇄할 수 있다.

주: 연도(X축), 요청 수 및 에너지 사용량(Y축)/일일 요청 수(진한 파랑), 요청 당 에너지(중간 파랑), 일일 총 에너지(연한 파랑)

성능 차이 없이 늘어나는 에너지 소모

교육처럼 정형화된 과제에서는 반드시 대형 모델이 필요한 것은 아니다. 70억 개 매개변수를 가진 소형 모델이 700억 개의 초대형 모델과 비교해도 에세이 평가나 퀴즈 생성 등에서는 성능 차이가 거의 없다. 하지만 전력 소모는 최대 10배까지 벌어진다. 문제는 여기서 끝나지 않는다. 더 강력한 모델이 등장하면 플랫폼은 이를 활용해 고해상도 이미지 생성, 음성 아바타 등 새로운 기능을 추가하고, 이에 따라 에너지 소비는 다시 높아진다. 절전 기술이 도입돼도 전체 소비는 줄지 않는 구조다.

에너지 아끼는 AI, 기술은 있다

AI의 연산 효율을 높이기 위한 기술도 개발되고 있다. '희소 전문가 혼합(Sparse Mixture of Experts, SMoE)' 구조는 매번 전체가 아닌 일부 연산만 수행해 계산량을 최대 80%까지 줄인다. '텐서 트레인 저순위 근사(Tensor Train Low-rank Approximation, TT-LoRA)'는 필요한 부분만 가볍게 조정하는 방식으로, 특화 모델을 더 적은 연산으로 훈련할 수 있게 한다. '드롭 업사이클링'은 기존 모델의 일부만 재훈련해 비슷한 성능을 훨씬 적은 전력으로 구현한다.

하드웨어도 진화 중이다. 광자 기반 연산 장치는 기존 전자 기반 GPU보다 에너지 효율이 10배 이상 높을 것으로 기대되며, 데이터를 메모리 내에서 직접 처리하는 방식도 전력 낭비를 줄일 수 있다. 하지만 이러한 기술이 상용화되기까지는 시간이 걸리고, 그 사이 AI 수요는 빠르게 증가하고 있다. 기술 발전 속도가 수요 증가를 따라가지 못하면 전체 에너지 절감 효과는 제한적일 수밖에 없다.

효율을 중심으로 바뀌는 규제 방향

AI의 전력 소비를 규제하는 방식도 바뀌어야 한다. 총 연산량을 제한하기보다, '백만 토큰당 몇 메가줄'이 들었는지를 기준으로 삼는 것이 더 현실적이다. 그러나 2025년 기준, 대형 언어모델의 80% 이상이 에너지 사용량을 공개하지 않았다. 전문가들은 ESG 기준처럼 에너지 사용 정보를 의무적으로 공개해야 한다고 강조한다.

연산 시점을 조정해 탄소 배출을 줄이는 방법도 있다. 예를 들어, 태양광·수력 등 청정에너지가 전력망에 많이 공급되는 시간대에 연산을 집중하면, 같은 전기를 써도 탄소 배출은 줄어든다. 이를 '탄소 기반 스케줄링'이라고 한다. 전력망의 실시간 탄소 배출 정보는 이미 공개돼 있지만, 클라우드 업체 대부분은 이를 연산 운영에 반영하지 않는다. 정부나 교육기관이 요금이 아닌 탄소 배출량을 기준으로 서비스를 선택한다면, 산업의 변화도 더 빨라질 수 있다.

미국 에너지부(United States Department of Energy, DOE)는 과거 고성능 컴퓨팅 지원 사업에서 연산 성능과 함께 전력 효율도 지원 조건으로 삼은 바 있다. 같은 방식으로, AI 연구소가 열 회수 장치나 태양광 설비를 갖추도록 유도하는 조건부 지원도 가능하다.

AI 쓰는 대학, 전력 장부도 써야 한다

대학도 AI 연산이 가져오는 전력 소비에 책임을 져야 한다. 예를 들어 학생 3만 명이 하루 10번씩 AI 튜터를 사용하면, 한 학기 동안 30MWh가 필요하다. 이는 기숙사 전체 조명 전력과 맞먹는다. 수업 설계에 이 전력 소비를 고려한다면, 퀴즈마다 고해상도 이미지를 생성할 필요가 있는지, 오프라인 모델로도 충분한지 판단할 수 있다. 교육과정 자체도 달라져야 한다. 공학은 알고리즘의 효율을 가르치지만, 그것이 실제로 얼마나 많은 전기를 사용하는지는 다루지 않는다. 경영학은 데이터 기반 전략을 강조하지만, 디지털 시스템이 남기는 탄소 발자국은 외면한다. 이제는 연산 비용도 설계 단계부터 고려해야 할 문제다.

연산도 공공성을 따라야 한다

AI 연산이 사용하는 전력의 탄소 배출량은 지역마다 크게 다르다. 아이슬란드는 지열 등 청정에너지가 풍부하지만, 폴란드는 석탄 비중이 높아 배출량이 많다. 이 때문에 일부 기업은 탄소 수치를 낮추기 위해 연산을 저탄소 국가로 이전한다. 단기적으로는 효과적인 감축처럼 보이지만, 문제는 기술적 효율을 개선하지 않은 채 수치만 낮추는 데 있다. 총 전력 사용량은 그대로인데, 청정 전력이 많은 지역에 연산을 집중시키면 공공 인프라의 전기 수요를 밀어낼 수도 있다. 실질적 감축 없이 ESG 점수만 관리하는 '탄소 세탁'이라는 비판이 나오는 이유다.

결국 중요한 건 연산 자원의 사용 우선순위다. 같은 1MW의 전력을 광고 문구 생성에 쓸 것인지, 전기버스를 움직이는 데 쓸 것인지 판단 기준이 필요하다. AI가 공공재로 기능하려면, 그 에너지 소비 역시 사회적 가치에 따라 배분돼야 한다.

계산의 미래, 설계의 선택

디지털 기술은 이미 교실과 사회적 공간을 대체하고 있다. 남은 과제는 이 기술이 남기는 탄소 발자국을 어떻게 줄일 것인가다. 연산을 절제하는 알고리즘, 에너지 효율을 높인 하드웨어, 공공성을 반영한 정책 설계가 필요하다. 기술의 진보는 속도보다 구조의 선택에 달려 있다.

본 연구 기사의 원문은 When Intelligence Pollutes: The Climate Cost of Our AI Future | The Economy 를 참고해주시기 바랍니다. 2차 저작물의 저작권은 The Economy Research를 운영 중인 The Gordon Institute of Artificial Intelligence에 있습니다.