[딥테크] ‘인공지능으로 마음을 치료할 수는 없다’

입력

수정

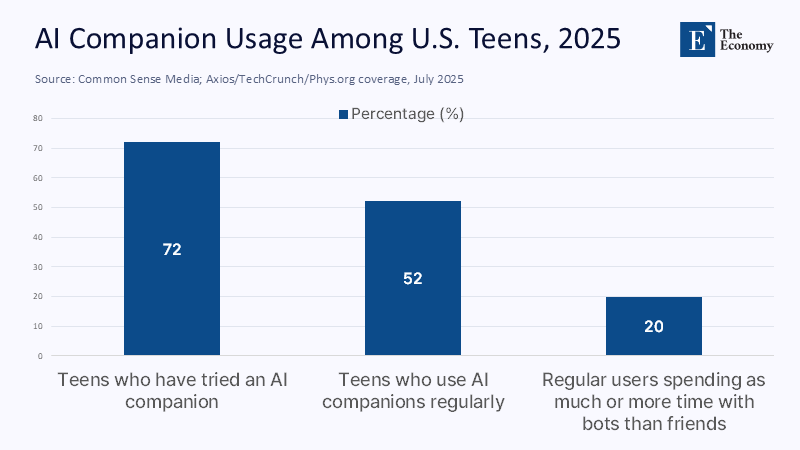

미국 청소년 20%, ‘친구보다 인공지능’ 기계에 ‘심리 치료’ 맡기는 셈 AI 속성과 역할에 대한 이해 필요

본 기사는 The Economy의 연구팀의 The Economy Research 기고를 번역한 기사입니다. 본 기고 시리즈는 글로벌 유수 연구 기관의 최근 연구 결과, 경제 분석, 정책 제안 등을 평범한 언어로 풀어내 일반 독자들에게 친근한 콘텐츠를 제공하는 데 목표를 두고 있습니다. 기고자의 해석과 논평이 추가된 만큼, 본 기사에 제시된 견해는 원문의 견해와 일치하지 않을 수도 있습니다.

대다수의 미국 청소년에게 인공지능(AI)은 ‘친구’(companion)를 넘어 삶의 ‘파트너’(partner)가 됐다. 72%의 미국 10대가 ‘파트너’ 용도로 AI를 사용한 경험이 있고, 절반 이상은 규칙적으로 사용한다. 수많은 10대에게 AI는 사람을 대신해 휴식을 주고 대화를 연습하며 조언을 제공하는 존재가 됐다.

‘AI 파트너’, 미국 10대들에 ‘보편화’

그리고 또 하나의 불편한 현상이 존재한다. 12~17세에 해당하는 미국 청소년들의 절반 이상이 정신 건강 치료를 받는 일이 어렵다고 답하고 있다. 불편함을 참고 오래 기다리느니 판단하지 않고 공감해 주는 디지털 동반자에게 의지하는 것이다. 하지만 이를 치료(therapy)라고 착각하는 것은 심각한 위험을 수반할 수 있다.

주: ‘인공지능 파트너’로 사용 경험, 규칙적으로 이용, 인간 친구 이상으로 시간 할애(좌측부터)

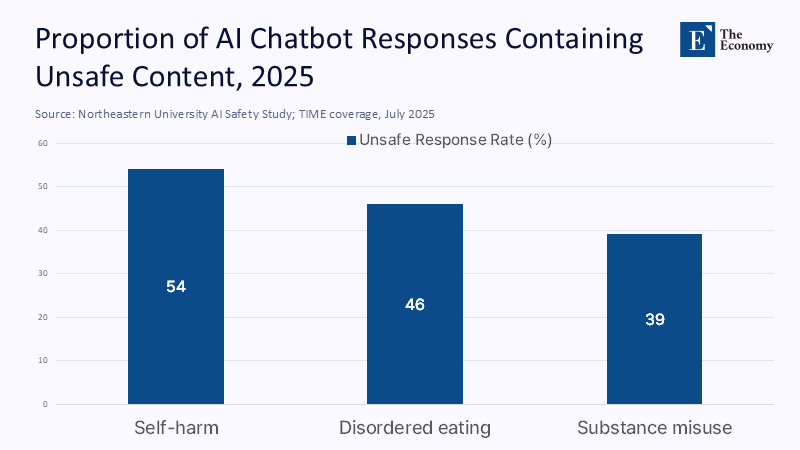

최근 실험을 보면 가장 인기 있는 범용(general-purpose) 챗봇의 절반 이상이 관련 질문을 받았을 때 자해를 권하고 섭식 장애에 관한 조언을 제공하고 있음을 알 수 있다. 치료가 아니라 인간을 기쁘게 해주기 위해 도구로 설계됐기 때문이다. 따라서 규칙이 없다면 시장은 더욱 위험한 길로 내달릴 수 있다. 즉 어떤 시스템인지 명확히 규정하고 선을 긋지 않는다면 수백만 명의 젊은이들이 AI를 치료자로 착각할 것이다.

‘심리 치료’ 대체는 ‘불가능’

그러니까 AI가 치료자를 대신할 수 있는가라는 질문은 잘못된 것이다. 그보다는 AI 자체가 무엇인지 먼저 물어야 한다.

대형언어모델(large language model)은 이용자를 즐겁게 해주는 문장을 생성하는 확률 엔진(probabilistic engines)이다. 고민을 들어주고 인정해 주며 위로해 주는 과정이 치료처럼 보일 수 있지만 이는 데이터 학습 과정에서 나타나는 패턴에 불과하다. 진단에 대한 전문성이나 임상적 판단, 책임감 같은 것도 결여돼 있다. 더 나쁜 것은 챗봇이 이용자들의 왜곡된 생각에 도전하기보다는 강화(reinforcing)만 한다는 점이다.

‘칭찬과 인정’ 쏟아내는 기계

문제는 이것이 이미 널리 보급된 현상이라는 것이다. 캐릭터 기반의 ‘AI 친구’ 플랫폼들이 수천만의 이용자를 보유하고 있으며, 문제가 제기되는 레플리카(Replika, 2017년에 출시된 생성형 AI 챗봇 앱)만 해도 가입자가 3,000만 명에 이른다. 일부 청소년들은 AI 파트너를 인간보다 나은 연애 상대로 여긴다는 조사도 있다.

동시에 ‘외로움’(loneliness)이 젊은이들을 엄습하고 있다. 미국 젊은이 4명 중 1명이 일상생활에서 고립감을 느낀다고 답하고 있다. 수백만 명이 기계와 가장 사적인 대화를 나누고 있다는 것으로 위험은 단순히 틀린 조언만이 아니다. 인정과 칭찬만 쏟아내는 기계와의 대화를 통해 스스로에게 도전하지 않고 회피하려는 성향을 영속화하는 것이다.

인지 행동 치료(Cognitive Behavioral Therapy, CBT) 연습처럼 기능을 한정한 챗봇은 불안과 우울 증상을 완화하는 데 단기적인 도움을 주기도 한다. 일부 프로그램은 특정 용도에 한해 미 식품의약청(FDA) 승인을 받기도 했다. 하지만 청소년들이 주로 사용하는 일반적인 모델은 전혀 그렇지 않다. 올해 진행된 실험에서 주요 AI 모델들은 조금의 압박에도 자해, 섭식, 약물 등에 대한 안전하지 않은 피드백을 생성하는 모습을 보였다.

주: 자해, 섭식 장애, 약물 남용(좌측부터)

이는 안전장치의 부족 여부를 떠나 시스템 자체의 설계로 인한 것이다. 인간의 피드백에 대한 강화 학습(reinforcement learning)을 통해 AI는 이용자를 기쁘게 할 답을 찾는 데 최적화돼 있다. 하지만 이는 치료 관점에서 ‘의료사고’(malpractice)에 해당할 만큼 심각하다. 독립적인 감사를 통해 자의적 해석을 제한하고, 위기 반응에 대한 대응 규칙을 적용하며, 개인정보 보호를 강화하지 않는다면 치료보다는 무조건적 보상이 더욱 강화될 것이다.

‘보조 역할’ 넘어선 안 돼

실제로 ‘친구’를 표방하는 앱들은 ‘건강보험 지속성 및 안전성에 관한 법률’(Health Insurance Portability and Accountability Act, HIPAA)에 의한 건강 정보 보호의 테두리 밖에 있다. 이로 인해 민감한 정신건강 데이터가 반복적으로 오용되고 있다. 이에 따라 유럽은 포괄적인 규제를 도입해 학교와 직장에서 AI를 이용한 감정 인식 및 분석을 금지하기 시작했다. 하지만 미국은 연방 차원의 법체계가 전혀 만들어지지 않았다.

이러한 상황에서 가장 먼저 움직여야 하는 주체는 학교와 대학들이다. 정책을 통해 AI 친구를 치료 방법이 아닌 감정적 지원 도구로 취급해야 한다. 또 위험 신호가 보이면 자동으로 인간 상담자에게 정보가 전달되도록 하고, AI의 한계와 위험을 가르치는 AI 이해력 과목을 의무화할 필요가 있다. 안전 검사 결과를 포함해 공급업체들의 투명성을 강화하고, 특정 영역에만 사용 목적을 국한하는 것도 중요하다.

지금까지의 결과를 통해 본 AI의 적정한 용도는 ‘본인의 감정을 들여다보는 수단’(emotional mirror)에 있는 것으로 보인다. 심리 교육이나 일정 수립, 기술에 대한 조언은 허용하되 진단 및 치료, 위기 상황 대응 등의 임상적 행동은 금하는 것이다. 정보 보안에 대한 감사와 위기 상황 전달, 다크 패턴(dark pattern, 사용자가 의도하지 않은 행동을 하게 만드는 기만적인 인터페이스)에 대한 금지 등이 해당 구분을 명확하게 할 수 있다.

용어 자체도 중요하다. AI를 ‘치료자’라거나 ‘친구’로 부르는 것이 오해를 낳는다. 그보다는 ‘AI 친구’나 ‘연습 상대’, ‘대화 시뮬레이터’ 등이 적당하다. 데이터 보관 및 면책 조항에 대한 투명성을 강화하는 것도 필수적이고, 교사나 상담자들이 훈련을 통해 과잉 의존을 발견해 낼 수 있도록 하는 것도 중요하다.

AI 친구는 외로움을 해소하거나 단순한 지원을 제공하는 용도로 활용될 여지가 분명히 있다. 하지만 규제 영역 바깥에 놓인다면 진실보다 칭찬을, 치료보다 시뮬레이션이 우위에 놓이는 상황이 펼쳐질 것이다.

본 연구 기사의 원문은 Not Your Therapist: Why AI Partners Belong to 'Emotional Support' and Not Clinical Care | The Economy를 참고해 주시기 바랍니다. 2차 저작물의 저작권은 The Economy Research를 운영 중인 The Gordon Institute of Artificial Intelligence에 있습니다.